2024 Python 计算生态八月推荐榜 第78期

24年8月10日 · Python123 2131 人阅读

|

看见更大的世界,遇见更好的自己

See a better world to meet better for ourselves.

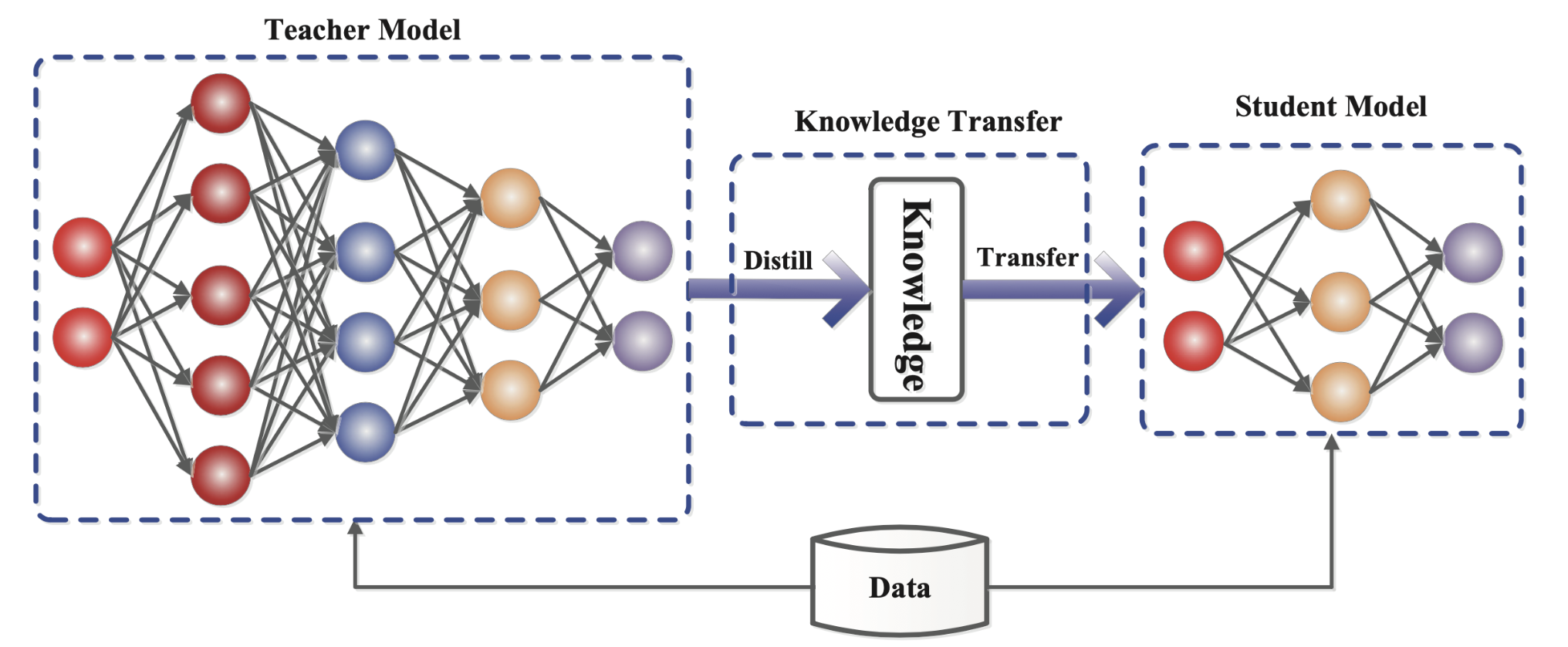

知识蒸馏(Knowledge Distillation)是一种模型压缩技术,旨在通过将一个大型、复杂的教师模型中学到的知识传递给一个较小的学生模型,从而在不显著降低性能的情况下减少模型的复杂度和计算开销。知识蒸馏的核心思想是利用教师模型的软标签来训练学生模型。软标签是指教师模型对每个类别的预测概率分布,而不仅仅是硬标签中的一个正确类别。知识蒸馏在实际应用中有着广泛的应用场景,例如在移动设备和嵌入式系统中部署深度学习模型时,通过知识蒸馏可以显著减少模型的参数量和计算量,从而提高模型的运行效率和响应速度。

2024年8月,随着机器学习和深度学习技术的不断发展,知识蒸馏作为一种模型压缩和优化技术,受到了越来越多的关注。特别推荐10款优秀的Python计算生态工具和框架,以帮助开发者更好地理解和应用知识蒸馏技术。

Distiller

Distiller 是一个用于神经网络压缩和加速的开源库,支持各种压缩技术,包括剪枝、量化和知识蒸馏。它提供了丰富的工具和范例,帮助开发者在深度学习模型中应用知识蒸馏。

https://github.com/IntelLabs/distiller

awesome-knowledge-distillation

awesome-knowledge-distillation

是一个精心整理的资源列表,专注于知识蒸馏领域的最新研究、工具和实践。这个列表旨在帮助研究人员、开发者和机器学习爱好者更好地理解和应用知识蒸馏技术。

https://github.com/dkozlov/awesome-knowledge-distillation

Neural Compressor

Neural Compressor 是一个用于优化深度学习模型的开源工具,支持知识蒸馏、剪枝和量化等多种技术。它提供了详细的文档和范例,帮助开发者在不同的深度学习框架中应用优化技术。

https://github.com/intel/neural-compressor

PyTorch Lightning Bolts

PyTorch Lightning Bolts 是一个扩展 PyTorch Lightning 的库,提供了多种预训练模型和实用工具,包括知识蒸馏的实现。它简化了深度学习模型的训练和部署流程,帮助开发者快速实验和应用知识蒸馏。

https://github.com/Lightning-Universe/lightning-bolts

model-optimization

TensorFlow Model Optimization Toolkit 是一个用于优化 TensorFlow 模型的工具包,支持剪枝、量化和知识蒸馏等多种技术。它提供了详细的文档和范例,帮助开发者在 TensorFlow 环境中应用知识蒸馏。

https://github.com/tensorflow/model-optimization

torchdistill

TorchDistill 是一个基于 PyTorch 的知识蒸馏框架,提供了多种蒸馏方法的实现。它支持从简单的软标签蒸馏到复杂的特征蒸馏,帮助开发者快速构建和实验不同的知识蒸馏方案。

https://github.com/yoshitomo-matsubara/torchdistill

random-network-distillation

random-network-distillation

是由 OpenAI 提供的一个开源项目,旨在实现和研究随机网络蒸馏(Random Network Distillation, RND)技术。RND 是一种用于强化学习(Reinforcement Learning, RL)中的探索策略,通过引导代理在未知或不熟悉的环境中进行有效探索,从而提高学习效率和效果。

https://github.com/openai/random-network-distillation

dataset-distillation

dataset-distillation 是一个开源项目,旨在实现和研究数据集蒸馏(Dataset Distillation)技术。数据集蒸馏是一种新颖的方法,通过将一个大型数据集的知识浓缩到一个小型数据集中,从而在保持模型性能的前提下,减少训练数据的数量。这对于加速训练过程和降低存储需求具有重要意义。

https://github.com/ssnl/dataset-distillation

KD_Lib

KD_Lib 是一个专注于知识蒸馏的轻量级库,提供了多种知识蒸馏算法的实现,包括传统的软标签蒸馏、特征蒸馏和对抗蒸馏等。其简洁的API设计使得知识蒸馏的应用变得更加容易。

https://github.com/SforAiDl/KD_Lib

transformers

Hugging Face Transformers 是一个流行的自然语言处理库,支持多种预训练模型和知识蒸馏技术。它提供了丰富的工具和教程,帮助开发者在 NLP 任务中应用知识蒸馏,提升模型性能和效率。

Python3Turtle