2023 Python 计算生态十月推荐榜 第68期

23年10月10日 · Python123 3257 人阅读

|

看见更大的世界,遇见更好的自己

See a better world to meet better for ourselves.

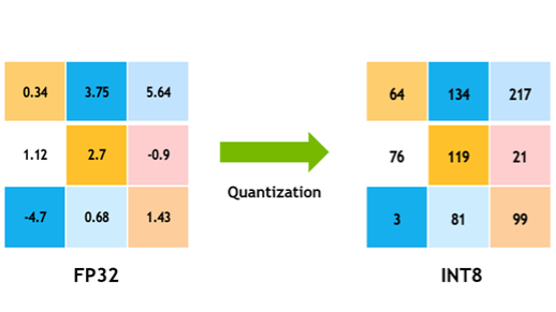

模型量化是近年来深度学习领域中被广泛讨论和应用的技术,它可以帮助优化深度学习模型的性能。模型量化是指通过减少模型的存储空间和计算需求,从而提高深度学习模型在推理阶段的效率。传统上,深度学习模型使用的是浮点数表示权重和激活值,这会占用较大的存储空间,并且需要较高的计算资源来进行推理。而模型量化则是将模型中的参数转换为低位宽的表示方式,如8位整数或4位整数,从而减少存储空间和计算需求,提高模型的性能。最常见的两种量化情况是float32 -> float16和float32 -> int8。

2023年10月,随着国内外海量大模型的开源,好事者特别推荐10款优秀的Python计算生态,帮助您了解模型量化技术。

bitsandbytes

bitsandbytes是对CUDA自定义函数的轻量级封装,特别是针对8位优化器、矩阵乘法(LLM.int8())和量化函数。

https://github.com/TimDettmers/bitsandbytes

Optimum

Optimum是huggingface transformers库的一个扩展包,用来提升模型在指定硬件上的训练和推理性能。

https://huggingface.co/docs/optimum/installation

PyTorch Quantization

PyTorch官方提供的模型量化库,支持整数量化和动态量化。

https://pytorch.org/docs/stable/quantization.html

TensorFlow Model Optimization

提供了一套用于模型量化的API和工具,支持各种量化方法和技术。

https://www.tensorflow.org/model_optimization/guide/install?hl=zh-cn

ppq

PPQ 是一个可扩展的、高性能的、面向工业应用的神经网络量化工具。

https://github.com/openppl-public/ppq

brevitas

专注于量化神经网络的PyTorch库,提供了丰富的量化方法和工具。

https://github.com/Xilinx/brevitas

HAWQ

PyTorch 的量化库。支持低精度和混合精度量化,通过TVM硬件实现。

https://github.com/Zhen-Dong/HAWQ

awesome-model-quantization

有关模型量化的论文、文档、代码列表。

https://github.com/htqin/awesome-model-quantization

GPTQ-for-LLaMa

使用GPTQ的LLaMA的量化。

https://github.com/qwopqwop200/GPTQ-for-LLaMa

brevitas

PyTorch 中的神经网络量化

Python3Turtle