2022 Python 计算生态七月推荐榜 第53期

22年7月10日 · Python123 2527 人阅读

|

看见更大的世界,遇见更好的自己

See a better world to meet better for ourselves.

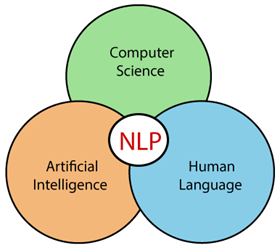

自然语言处理( Natural Language Processing, NLP)是计算机科学领域与人工智能领域中的一个重要方向。中文自然语言处理与英文自然语言处理在词性标注、句法分析等任务上颇有差异,主要体现在英语有明显的屈折变化(单复数、时态等)而汉语缺少这些屈折变化,亦即有学者总结的“汉语重义合,英语重形合”,英语里一个词被标为动词还是名词,没有太多争议,汉语里一个词应该被标为动词还是名词,例如“热爱学习”、“劳动光荣”中的“学习”、“劳动”如果按照英文语法规范应当标注为名词,语言学家沈家煊先生就曾提出“汉语动词和名词不分立”的理论。从更广阔的语言研究角度而言,中英由于各自承载了两种截然不同的人类群体的文化信息,所以在更深层的文化内涵会有更明显的分野。

2022年07月,中文NLP相关的工具包越来越多了,包括jieba、哈工大的LTP、清华的THULAC、北大的pkuseg,好事者特别推荐10款优秀的Python计算生态,帮助您了解Python的中文自然语言处理。

jieba

“结巴”中文分词,最好的 Python 中文分词工具。

https://github.com/fxsjy/jieba

LTP

LTP(Language Technology Platform) 提供了一系列中文自然语言处理工具,用户可以使用这些工具对于中文文本进行分词、词性标注、句法分析等等工作。

https://github.com/HIT-SCIR/ltp

THULAC

THULAC(THU Lexical Analyzer for Chinese)由清华大学自然语言处理与社会人文计算实验室研制推出的一套中文词法分析工具包,具有中文分词和词性标注功能。

pkuseg

一个多领域中文分词工具包。

https://github.com/lancopku/pkuseg-python

LAC

LAC全称Lexical Analysis of Chinese,是百度自然语言处理部研发的一款联合的词法分析工具,实现中文分词、词性标注、专名识别等功能。

HanLP

面向生产环境的多语种自然语言处理工具包,基于PyTorch和TensorFlow 2.x双引擎,目标是普及落地最前沿的NLP技术。HanLP具备功能完善、精度准确、性能高效、语料时新、架构清晰、可自定义的特点。

https://github.com/hankcs/HanLP

fastNLP

fastNLP是一款面向自然语言处理(NLP)的轻量级框架,目标是快速实现NLP任务以及构建复杂模型。

https://github.com/fastnlp/fastNLP

xmnlp

一款开箱即用的开源中文自然语言处理工具包。

https://github.com/SeanLee97/xmnlp

Chinese-Annotator

一个开发中的中文文本标注工具。

https://github.com/deepwel/Chinese-Annotator

Jiagu

Jiagu使用大规模语料训练而成,提供中文分词、词性标注、命名实体识别、情感分析、知识图谱关系抽取、关键词抽取、文本摘要、新词发现、情感分析、文本聚类等常用自然语言处理功能。

Python3Turtle